本文共 4888 字,大约阅读时间需要 16 分钟。

本节书摘来自异步社区《精通VMware vSphere 6》一书中的第2章,第2.1节,作者:【美】Nick Marshall(马歇尔) , Grant Orchard(欧查德) , Josh Atwell(特威尔)著,更多章节内容可以访问云栖社区“异步社区”公众号查看

第2章 规划与安装 VMware ESXi

第1章已经详细介绍了VMware vSphere套件及其应用程序,我们由此了解到VMware ESXi是vSphere的基础。虽然安装十分简单,但要成功部署和配置VMware ESXi,必须正确规划基于VMware实现的环境。

2.1 规划VMware vSphere部署

部署VMware vSphere不仅是将服务器虚拟化。和物理服务器一样,vSphere部署也会影响到存储、网络和安全性。由于这些方面对组织中许多的IT组件都会产生重大影响,因此vSphere 部署的规划过程也变得非常重要。如果没有正确的规划过程,vSphere实现就会出现诸多风险,包括配置问题、不稳定性、不兼容性和影响成本等风险。

在vSphere部署的规划过程中,需要解决下面这些问题(这些仅仅只是部分问题)。

使用哪些类型的服务器作为底层物理硬件?

使用哪些类型的存储,以及如何将存储连接到服务器?如何配置网络?在某些时候,解决这些问题,也就解决了其他问题。在解决这些问题之后,也可能转向更难的问题。这些问题包括:vSphere 部署将如何影响员工、业务流程和运营流程。本节并不会解答这些问题;相反,此处只关注于技术问题。vSphere设计本身就不简单

本章的2.1节仅仅概括介绍了规划与设计vSphere部署的相关信息。vSphere设计本身就是一个非常复杂的问题,足够用一本书来介绍。有兴趣想要更详细地了解设计决策和设计影响的读者,可以阅读2013年出版的第2版《VMware vSphere Design》(Sybex)。

后面的章节将介绍前面所列的3个重要问题(计算平台、存储和网络),因为这些问题是规划vSphere部署的关键部分。2.1.1 选择服务器平台

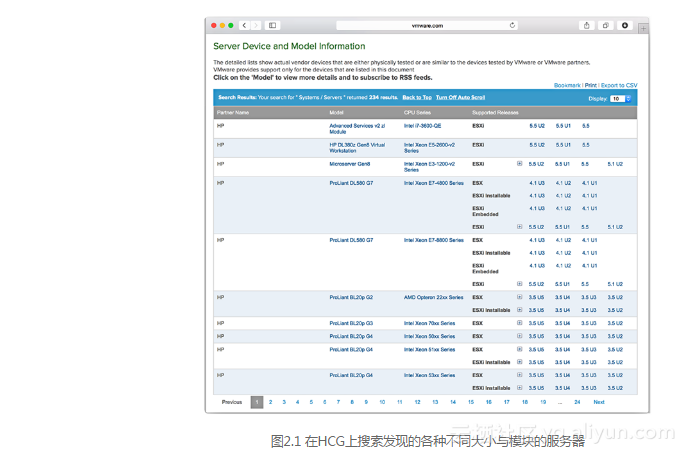

在规划vSphere部署时,第一个重要决策就是选择硬件平台(或“计算”平台)。与传统操作系统(如Windows或Linux)相比,ESXi有着更为严格的硬件限制。ESXi不一定支持市面上所有的存储控制器或网络适配器。虽然硬件限制减少了部署所支持虚拟基础架构的选择,但是它们能够保证硬件经过测试,而且能够按照ESXi的要求工作。虽然并非所有供应商或白盒配置都可以运行ESXi的主机,但是随着VMware测试更多供应商的新设备,它所支持的硬件平台列表会继续增加和变化。使用VMware网站上支持搜索的兼容性指南(Compatibility Guide):www.vmware.com/resources/compatibility/,用户就可以检查硬件的兼容性。该网站可以快速搜索大量的主流供应商系统,如惠普、思科、IBM和戴尔。例如,在编写本书时,在兼容性指南上搜索惠普(HP)或戴尔(Dell)会返回 200多个结果,其中包括支持vSphere 5到6版本的刀片服务器和传统机架服务器。在主流供应商中(如惠普、思科、IBM和戴尔),通常很容易找到支持ESXi并通过测试的平台,特别是在硬件的新模块上。如果将硬件列表扩大到其他供应商,那么会有更多vSphere支持的兼容服务器可供选择。

用正确的服务器完成正确的工作

选择正确的服务器无疑是保证成功部署vSphere的第一步,也是保证VMware提供必要支持的唯一方法。但是,要注意第1章介绍的内容—服务器并不是越大越好!

寻找支持的服务器仅仅是第一步。同样重要的是要寻找正确的服务器—能够正确平衡容量与经济承受能力的服务器。是否使用更大的服务器,如支持4个或更多物理CPU和512GB RAM的服务器?或者选择较小的服务器更为合适,如支持双物理CPU和256 GB RAM的服务器?不断地给服务器增加更多的物理CPU和RAM,会遇到一个回报衰减点。一旦通过这个点,服务器购买和支持的成本就越昂贵,但是服务器可运行的虚拟机数量增加却无法抵销增加的成本。根据你选择服务器的目的,你可能会发现可接受的风险要比用一些服务器能达到的最大固结比的风险小。因此,问题在于找到有足够增长空间并且有符合需求的资源数量的服务器模块。幸好,更深入地了解特定供应商(如惠普)提供的服务器模块,就可以找到各种类型和大小的服务器模块(见图2.1),其中包括:

- 半高C级刀片服务器,如BL460c和BL465c;

- 全高C级刀片服务器,如BL685c;

- 双插槽1U服务器,如DL360;

- 双插槽2U服务器,如DL380和DL385;

- 四插槽4U服务器,如DL580和DL585。

注意,图2.1的列表上并没有显示vSphere 6。在编写本书时,VMware HCG还没有更新和添加vSphere 6的信息。然而,一旦VMware更新HCG并且供应商完成他们的测试后,就可以使用VMware的在线HCG查看vSphere 6的兼容硬件了。硬件只要通过了认证,就会添加到这个列表上,而不是只在主要vSphere发布的时候才添加。

哪一个服务器才是正确选择呢?这个问题的答案取决于很多因素。CPU内核数量通常作为一个决定因素,但还应该考虑RAM插槽总数。RAM插槽数量越多,意味着即使使用更低价格和密度的RAM模块,同样也可以实现较高的内存配置。此外,还应该考虑服务器扩展方式,如服务器提供的快速外部设备互连(Peripheral Component Interconnect Express,PCIE)总线、扩展插槽和扩展卡。最后,一定要考虑服务器的成型因子:刀片服务器与机架服务器有各自的优点和缺点。

2.1.2 确定存储架构

选择正确的存储方案是部署vSphere过程中要考虑的第二个因素。vSphere提供的高级特性(如vSphere DRS、vSphere HA和vSphere FT等),都取决于共享存储架构。虽然我们不会深入讨论存储硬件的特定品牌,但第6章会介绍VMware在vSphere 6中发布的虚拟SAN(VSAN)功能。如上所述,由于对共享存储的依赖性,为vSphere部署选择正确的存储架构同样是影响ESXi服务器硬件选择的重要依据。HCG不仅包含服务器信息

VMware的HCG不仅仅包含服务器信息。可搜索的HCG还提供了存储阵列及其他存储组件的兼容信息。一定要使用可搜索的HCG验证主机总线适配器(HBA)和存储阵列的兼容性,保证其达到适当的VMware支持级别。

VMware还通过产品互操作性矩阵(Product Interoperability Matrix)提供了软件的兼容信息,请参考以下网址:

http://www.vmware.com/resources/compatibility/sim/interop_matrix.php

以太网光纤通道支持需要什么

以太网光纤通道(FCoE)是一种相对较新的存储协议。然而,因为FCoE在设计上兼容光纤通道,所以对于ESXi而言,它的表现、行为和操作都和光纤通道一样。只要有FCoE聚合网络适配器(CNA)的驱动程序—同样可以在VMware HCG上搜索到,那么FCoE支持就不难。

在选择正确的存储解决方案时,必须考虑以下问题。哪一种存储能够与现有存储或网络基础架构整合?

你是否使用过或精通某一些存储?这个存储解决方案是否能够在当前环境中实现符合要求的性能?这个存储解决方案是否提供了某种形式的vSphere高级整合方法?2.1.3 整合网络基础架构

在规划过程中,第三个重要决策是如何将vSphere整合到现有的网络基础架构上。这个决策一定程度上取决于服务器硬件和存储协议的选择。例如,一个选择使用刀片服务器的组织可能会发现特定刀片服务器所提供的网络接口卡(NIC)不够用。这会影响vSphere实现与现有网络的整合。类似地,有一些组织选择使用iSCSI或NFS,而不使用光纤通道,他们通常不得不在ESXi主机上部署更多的NIC,或者使用10吉比特以太网才能容纳传统网络流量。此外,一些组织还需要为vMotion和vSphere FT预留网卡。

在10吉比特以太网流行之前,许多vSphere部署环境的ESXi都至少有6个NIC,甚至通常有8、10或12个NIC。为什么要使用如此多的NIC呢?

- ESXi管理网络至少需要1个NIC。强烈推荐增加1个冗余NIC。事实上,如果主机没有为管理网络提供冗余网络连接,那么一些 vSphere 特性(如vSphere HA)会发出警告信息。

- vMotion需要使用1个NIC。同样,强烈推荐增加1个冗余NIC。这些NIC至少应该使用1吉比特以太网。在某些时候,这些流量可以安全地与ESXi管理流量组合在一起,因此可用2个NIC同时处理ESXi管理流量和vMotion流量。

- 如果使用vSphere FT特性,那么至少需要1个NIC。同样推荐增加1个冗余NIC。这个NIC至少是1吉比特以太网NIC,根据VM支持的FT有多少个vCPU,可能需要10吉比特以太网NIC。

- 在使用iSCSI、NFS或VSAN的部署环境中,至少还需要增加1个NIC,最好是2个。这里必须使用1吉比特以太网或10吉比特以太网。虽然可以使用1个NIC,但是强烈推荐使用2个以上NIC。

- 最终,至少要用2个NIC处理来自虚拟机本身的流量。强烈推荐使用1吉比特以太网以上的链路来传输虚拟机流量。

现在每一台服务器总共需要8个NIC(同样,这里假设管理端和vMotion共享一对NIC)。在这种部署方案中,还需要保证有数量足够多且速度足够快的网络端口,才能满足vSphere部署的需求。当然,现在讨论的只是vSphere的基本网络设计,还不涉及10吉比特以太网、FCoE(这个存储协议也会影响网络设计)或虚拟交换基础架构等。所有这此因素都会影响网络配置。

使用万兆以太网NIC

如何将一个vSphere部署与现有网络基础架构整合,这里涉及许多因素。例如,最近几年万兆以太网的数据中心变得十分普遍,这种带宽从根本上改变了虚拟网络的设计形式。

在一个特殊案例中,企业希望将现有机架服务器集群升级至6个NIC,再将2个光纤通道HBA升级至2个端口的10吉比特以太网CAN。这在物理角度和逻辑配置方面都与以前的交换机有着明显的不同。很明显,这允许主机拥有更大的带宽和更灵活的设计。

最后一个设计是使用VMware网络IO控制(NOIC)和基于负载的组合(Load-Based Teaming, LBT)在必要的流量类型之间共享带宽,并在网络拥塞时限制带宽。从而在不需要太多复杂配置的前提下就可以有效使用新的带宽性能。第5章将详细介绍网络。

在解决这3个问题之后,我们至少已经建立了vSphere部署的基本环境。正如前面所介绍的,这一节还没有全面介绍vSphere解决方案的设计。但是,建议一定要寻找关于vSphere设计的资料,并且全面考虑设计实践的各个方面,然后再真正开始部署vSphere。转载地址:http://cbrsx.baihongyu.com/